Selon les titres à la une du jour, l’IA est tantôt une panacée, tantôt un grand malheur. Elle peut nous aider à résoudre tous les problèmes du monde pour peu que nous demandions à l’algorithme comment faire. Mais elle peut aussi vous prendre votre travail et devenir trop intelligente pour son propre bien. La vérité, comme toujours, se situe quelque part entre les deux. L’IA aura probablement de nombreux impacts positifs qui ne changeront pas la face du monde, tout en offrant sa part de négativité, sans que cela ne soit une menace pour la société. Répondre à quelques questions intéressantes sur l’utilisation appropriée de l’IA peut permettre de trouver le juste milieu.

1. Peut-on utiliser l’IA sans supervision humaine ?

Répondre à cette question de manière exhaustive nécessiterait sans doute d’écrire plusieurs livres, mais nous n’irons pas jusque-là. Concentrons-nous plutôt sur un cas d’utilisation de plus en plus populaire et démocratisé : les assistants d’IA générative. Sans doute avez-vous déjà utilisé ChatGPT, Bard ou l’une des dizaines de plateformes accessibles à toute personne disposant d’un ordinateur. Mais pouvez-vous solliciter ces algorithmes et être entièrement satisfait de ce qu’ils produisent ?

Pour faire court, la réponse est « non ». Ces chatbots sont tout à fait capables d’avoir des hallucinations, c’est-à-dire de produire des réponses inventées par l’IA. Les réponses fournies proviennent de l’ensemble de données d’entraînement de l’algorithme, mais peuvent ne pas être rattachées à des connaissances réelles. Prenons l’exemple récent d’un avocat qui présentait un dossier dans une salle d’audience. Il s’est avéré qu’il avait utilisé ChatGPT pour rédiger l’intégralité du dossier et que l’IA faisait référence à de fausses affaires pour étayer le dossier.

En matière d’IA, il est probable qu’une supervision humaine sera toujours nécessaire. Que l’algorithme analyse des modèles météorologiques pour prédire les précipitations ou qu’il évalue un modèle d’entreprise, il reste susceptible de commettre des erreurs ou même de fournir des réponses dépourvues de toute logique. L’utilisation appropriée de l’IA, en particulier avec des outils tels que ChatGPT et ses équivalents, nécessite un intervenant humain pour vérifier les faits.

2. Les créateurs d’IA peuvent-ils corriger les biais algorithmiques après coup ?

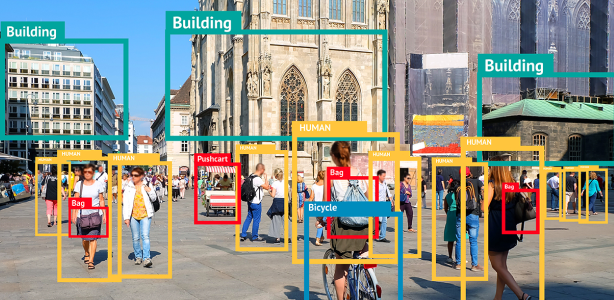

Là encore, il s’agit d’une question plus complexe que ne le permet cette tribune. Nous pouvons toutefois tenter d’examiner une application plus étroite de la question. De nombreux algorithmes d’IA utilisés dans le monde réel se sont révélés avoir un comportement discriminatoire. Par exemple, un algorithme d’IA affichait un taux d’erreur beaucoup plus important en fonction du sexe ou de l’origine ethnique des sujets. Un autre a classé de manière incorrecte le risque présenté par des détenus, avec pour résultat des taux de récidive démesurés.

Les créateurs de ces algorithmes peuvent-ils donc résoudre ces problèmes une fois que le modèle est mis en service ? Oui, les ingénieurs peuvent toujours revoir leur code et tenter de le corriger après publication des modèles. Cependant, le processus d’évaluation et d’audit peut être une tâche sans fin. Les créateurs d’IA devraient plutôt s’attacher à intégrer des valeurs dès les premiers stades de la conception de leurs modèles.

La fiabilité des résultats des algorithmes dépend directement des données sur lesquelles ils ont été entraînés. Si un modèle est entraîné sur un ensemble de données disproportionné par rapport à l’ensemble qu’il tente d’évaluer, ces biais inhérents apparaîtront inévitablement une fois que le modèle sera mis en service. Aussi robuste que soit un modèle, il lui manquera toujours la compréhension humaine fondamentale de ce qui est bien ou mal. De plus, il y a peu de chances qu’il soit en mesure de déterminer si un utilisateur l’emploie avec des intentions malveillantes.

Bien que les créateurs puissent apporter des modifications une fois les modèles élaborés, la meilleure ligne de conduite est de veiller à ancrer les valeurs que l’IA doit incarner dès le premier jour.

3. Qui est responsable des actions d’une IA ?

Il y a quelques années, un véhicule autonome a heurté et tué un piéton. La question au centre de l’attention à la suite de cet accident était : « Qui est responsable ? ». Uber, qui était propriétaire de la voiture ? Le conducteur de la voiture ? Dans cette affaire, le conducteur du véhicule, qui était assis dans la voiture, a été accusé de mise en danger.

Mais qui aurait été responsable si la voiture avait été vide et entièrement autonome ? Que se passerait-il si une voiture autonome renversait un piéton en train de traverser la rue parce que le feu de signalisation était de la bonne couleur ? Face à l’intensification de l’utilisation de l’IA dans le domaine public, la question de la responsabilité se pose avec acuité.

Certaines juridictions, dont l’Union européenne, travaillent actuellement à l’élaboration d’une législation régissant la responsabilité de l’IA. Cette législation s’efforcera d’établir différentes « obligations pour les fournisseurs et les utilisateurs en fonction du niveau de risque associé à l’IA ».

Il est dans l’intérêt de tous de faire preuve de la plus grande prudence lors de l’utilisation de l’IA. Le conducteur de la voiture autonome aurait pu être plus attentif à la route, par exemple. Les personnes qui partagent du contenu sur les réseaux sociaux peuvent faire preuve d’une plus grande vigilance afin d’éviter de partager des deepfakes ou toute autre forme de contenu généré par l’IA.

4. Comment trouver un équilibre entre les avantages de l’IA et les préoccupations en matière de sécurité et de confidentialité ?

Il s’agit peut-être de la question la plus urgente de toutes celles liées à l’utilisation appropriée de l’IA. Tout algorithme a besoin de vastes quantités de données d’entraînement pour évoluer. Si un modèle est destiné à évaluer des personnes réelles dans le cadre de la lutte contre la fraude, par exemple, il devra probablement être formé sur la base d’informations réelles. Comment les entreprises peuvent-elles s’assurer que les données qu’elles utilisent ne risquent pas d’être volées ? Comment les particuliers peuvent-ils savoir quelles informations ils partagent et à quelles fins celles-ci sont utilisées ?

Cette question globale recouvre clairement toutes ces questions plus petites et plus spécifiques qui tentent d’aller au cœur du sujet. Le plus grand défi lié à ces questions pour les particuliers est de savoir s’ils peuvent faire confiance aux entreprises qui utilisent ostensiblement leurs données à bon escient ou de manière sécurisée.

5. Les particuliers doivent prendre des mesures pour s’assurer que leurs informations sont utilisées de manière appropriée

Les particuliers qui s’inquiètent de savoir si leurs informations sont utilisées pour l’entraînement de l’IA ou si elles sont exposées à d’autres risques peuvent prendre certaines mesures. La première consiste à toujours sélectionner les cookies lorsqu’ils naviguent en ligne. Depuis l’entrée en vigueur du RGPD et de la CCPA (California Consumer Privacy Act), pratiquement toutes les entreprises qui font des affaires aux États-Unis ou dans l’Union européenne doivent placer sur leur site Web un avertissement indiquant qu’elles collectent des informations lors de la navigation. Vérifier ces préférences est un bon moyen d’empêcher les entreprises d’utiliser des informations si tel n’est pas votre souhait.

La seconde consiste à tirer parti d’outils tiers tels que McAfee+, qui propose des services comme des VPN et la protection de la confidentialité et de l’identité au sein d’une plateforme de sécurité complète. Grâce à la protection complète contre le vol d’identité, une couche de sécurité supplémentaire est ajoutée à vos choix en matière de cookies et aux autres bonnes habitudes de navigation que vous avez prises. Ne vous contentez pas d’espérer que vos données seront utilisées de manière appropriée — agissez et protégez-les dès aujourd’hui.